para Comércio Electrónico

por

Henrique Daniel de Avelar Lopes Cardoso

Tese de Mestrado em Inteligência Artificial e Computação

Orientada por

Professor Doutor Eugénio Oliveira

Faculdade de Economia

Universidade do Porto

1999

Henrique Daniel de Avelar Lopes Cardoso nasceu em Cedofeita Porto, no dia 12 de Agosto de 1974. Licenciou-se em Informática de Gestão, pela Universidade Portucalense, em Abril de 1997.

Foram várias as pessoas que me mostraram este mundo fascinante que é a Inteligência Artificial. Agradeço em particular ao meu professor e orientador, o Professor Doutor Eugénio Oliveira, pela forma como me incentivou na elaboração desta tese.

Gostaria também de agradecer a todos os membros do NIAD&R, pela forma como me acolheram, integraram e ajudaram. A todos os meus colegas de mestrado, pelo seu companheirismo. Ao Max Schaefer, pela sua colaboração e contribuição em algumas das ideias que estão na base deste trabalho.

Agradeço ainda à Fundação para a Ciência e a Tecnologia, por ter apoiado financeiramente este trabalho, pelo Subprograma Ciência e Tecnologia do 2º Quadro Comunitário de Apoio.

Finalmente, agradeço aos meus pais por todo o apoio que me deram quando optei pelo ingresso no mestrado e durante estes dois anos de duração.

O Comércio Electrónico tem sofrido um crescimento explosivo, acompanhando a evolução da Internet. Contudo, há ainda poucas estruturas de suporte a esta nova forma de comércio, que hoje se resume, em grande parte, ao anúncio e encomenda electrónicos.

Este trabalho foi motivado pela criação de um sistema de suporte ao Comércio Electrónico mediado por agentes. Sendo assim, tem como base a utilização de agentes de "software" em negociação automática. Além disso, pretendemos estudar e desenvolver a utilização de um tipo particular de aprendizagem na negociação entre os agentes.

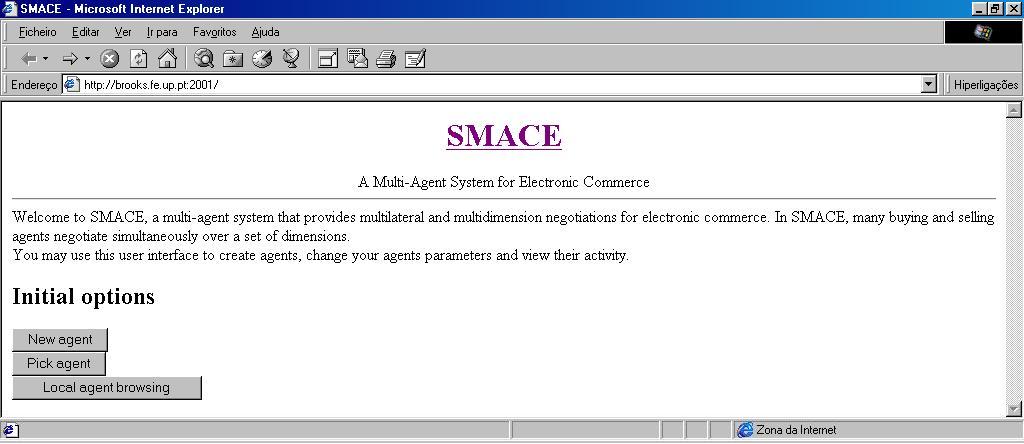

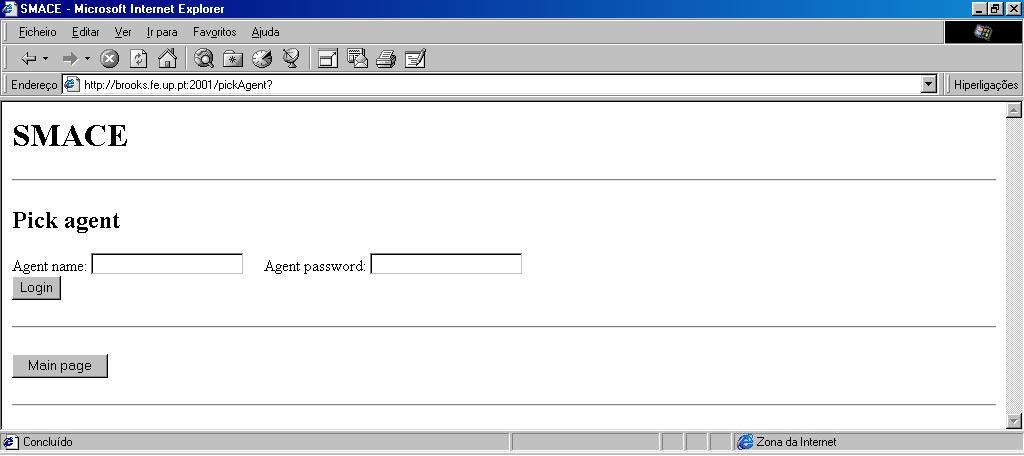

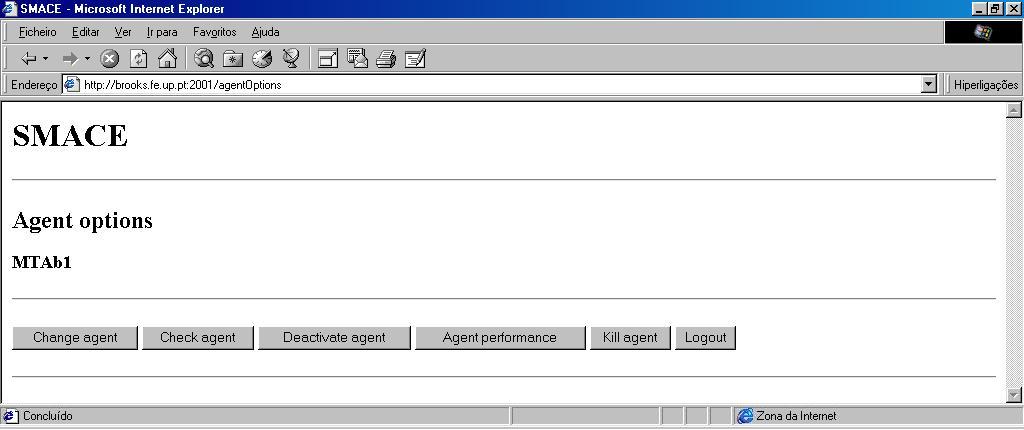

Assim, desenvolvemos um sistema denominado SMACE (Sistema Multi-Agente para Comércio Electrónico), permitindo que os utilizadores deleguem intenções de compra ou venda em agentes de "sofware" que negoceiam autonomamente, segundo um modelo de negociação multi-lateral (várias negociações simultâneas) e multi-dimensão (a negociação pode decorrer sobre vários atributos). O sistema foi utilizado como uma plataforma de testes de diferentes estratégias de negociação, permitindo ainda que agentes criados externamente interajam no mercado do SMACE. De facto, este sistema consiste numa plataforma que facilita a construção de agentes de "software" para Comércio Electrónico, que negoceiam segundo o modelo e protocolo de negociação adoptados. Os agentes podem ser criados através de uma API construída para o efeito.

Esta plataforma permitiu-nos avaliar o desempenho de agentes dotados de capacidades de aprendizagem, baseada na interacção com o ambiente. O algoritmo de aprendizagem implementado foi sendo sucessivamente adaptado, de modo a propiciar um melhor desempenho dos agentes no processo de negociação.

Os resultados obtidos mostram que a aprendizagem em negociação, e em especial no domínio do Comércio Electrónico, é possível. No entanto, dado o dinamismo dos mercados em geral, tal tarefa não é fácil.

Electronic Commerce has undergone an explosive growing, following closely the evolution of the Internet. Yet, there are few supporting structures to this new form of commerce, which today mostly resumes to the electronic announcement and ordering.

This work was motivated by the creation of a system to support agent-mediated Electronic Commerce. So, it is based on using software agents in automated negotiation. Besides that, our intention was to study and develop the implementation of a certain kind of learning in the agents negotiation process.

Therefore, we developed a system which we called SMACE (Multi-Agent System for Electronic Commerce), allowing the users to delegate buying or selling intentions to software agents that negotiate autonomously, following a multi-party (multiple simultaneous negotiations) and multi-issue (negotiation can be made over a set of attributes) negotiation model. The system was used as a testing platform for different negotiation strategies, also allowing externally created agents to interact in the SMACE market. In fact, this system consists of a platform that facilitates the construction of software agents for Electronic Commerce purposes, which negotiate under the adopted negotiation model and protocol. The agents can be created through an API built to that end.

This platform allowed us to evaluate the performance of agents enabled with learning capabilities, which are based on the interaction with the environment. The learning algorithm implemented was progressively adapted, in order to allow for better agents performance in the negotiation process.

The results obtained show that learning in negotiation, and especially

in the Electronic Commerce domain, is possible. However, due to the dynamics

of the markets in general, such task is not easy to accomplish.

Introdução *

1. Comércio Electrónico *

1.2 A Expansão de Mercados Electrónicos *

2.1.1 Agente *

2.1.2 Comunicação *

2.1.3 Plataformas *

2.2 O Modelo Consumer Buying Behaviour (CBB) *

2.2.1 Selecção do Produto *

2.2.2 Selecção do Vendedor *

2.2.3 Negociação *

3.2 Leilões Electrónicos *

3.3 Outros Estudos *

4.2 Fishmarket *

4.3 Kasbah *

4.4 Tete-a-Tete *

4.5 Comparação *

6.2 Modelo de Negociação *

6.3 Protocolo de Negociação *

6.4 Plataforma e Comunicação *

6.4.1 SMACE e JATLite *

6.4.2 SMACE e KQML *

6.5 Aprendizagem *

6.6. Implementação *

6.6.1 Encontro de Agentes *

6.6.2 Dimensões de Negociação *

7.2 Tácticas Dependentes de Recursos *

7.2.1 Tácticas de Tempo Máximo de Negociação Dinâmico *

7.2.2 Tácticas de Estimativa de Recursos *

7.3 Tácticas Dependentes do Comportamento *

7.3.1 Imitação Proporcional *

7.3.2 Imitação Absoluta *

7.3.3 Imitação Proporcional Média *

8.2 Estratégias Adaptativas *

9.1.1 Cálculo da Função de Valor *

9.1.2 Escolha de Acções *

9.2 Implementação do Algoritmo de Aprendizagem-Q *

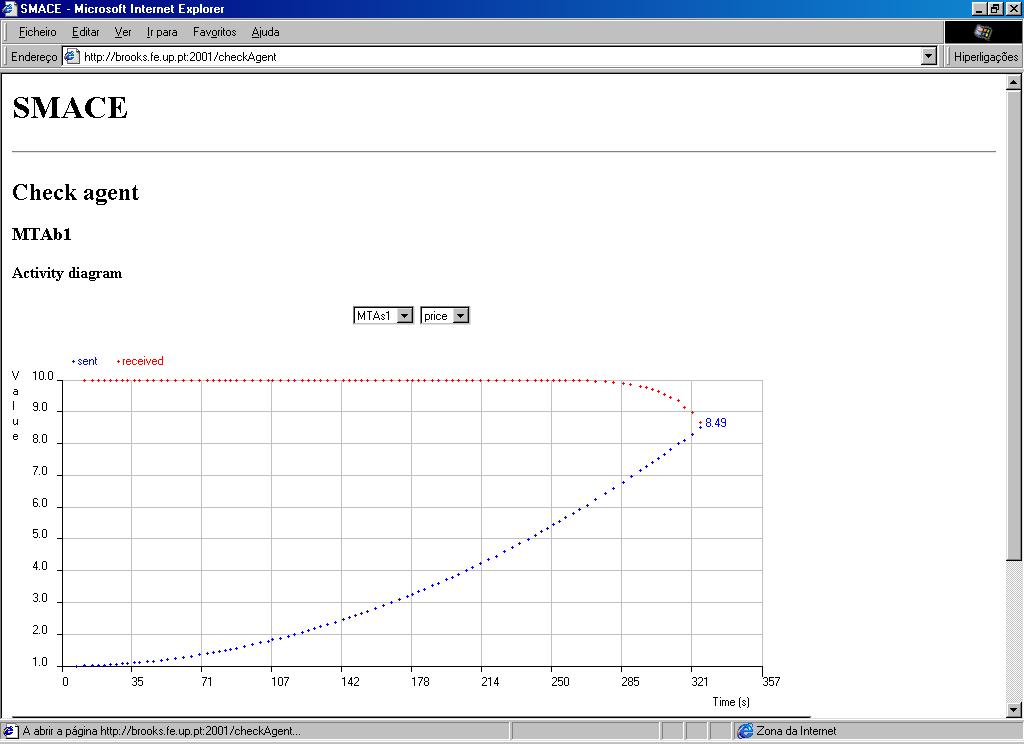

10.1.1 Experiências com Agentes MTA *

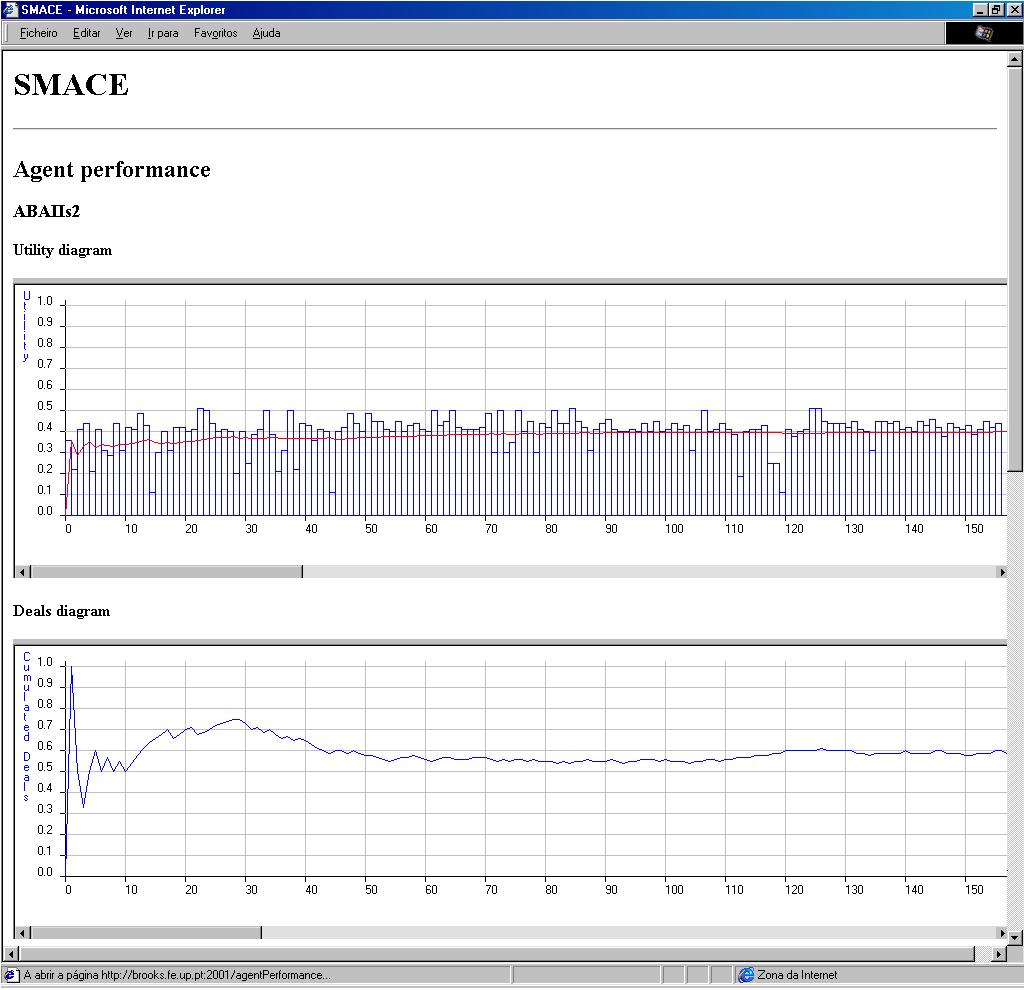

10.2 Experiências Iniciais com Agentes ABA *

10.2.1 Configuração dos Cenários *

10.2.2 Resultados *

10.2.3 Análise dos Resultados *

10.3 Melhorias no Algoritmo de Aprendizagem *

10.3.1 Valores Iniciais Optimistas *

10.3.2 Função de Reforço *

10.3.3 Técnica dos "After-States" *

10.4 Experiências com Agentes ABA Melhorados *

10.4.1 Configuração dos Cenários *

10.4.2 Resultados *

APÊNDICES *

B KQML *

C Mensagens KQML entre Agentes e o Mercado *

D Mensagens KQML entre Agentes de Mercado *

ANEXOS *

Figura 2.1 Arquitectura básica de um agente *

Figura 2.2 Comunicação entre agentes *

Figura 2.3 Protocolo da Rede Contratual *

Figura 6.1 Esquema do mercado *

Figura 6.2 Problema de acordos simultâneos *

Figura 6.3 Problema de "deadlock" *

Figura 6.4 Actividade do fluxo de negociação entre dois agentes *

Figura 6.5 Abordagem inicial SMACE e JATLite *

Figura 6.6 Abordagem SMACE e JATLite *

Figura 6.7 SMACE API *

Figura 6.8 Encontro de agentes *

Figura 9.1 Representação de um Estado *

Figura 10.1 Funções polinomiais utilizadas nos agentes ABA *

Figura 10.2 Curvas de negociação dos agentes MTA nos cenários 3 e 4 *

Figura 10.3 Utilidades e utilidade média do agente 1ABAs1 *

Figura 10.4 Utilidades e utilidade média do agente 2ABAs1 *

Figura 10.5 Percentagem de acordos obtidos pelo agente 3ABAs1 *

Figura 10.6 Utilidades e utilidade média do agente 3ABAs1 *

Figura 10.7 Percentagem de acordos obtidos pelo agente 4ABAs1 *

Figura 10.8 Utilidades e utilidade média do agente 4ABAs1 *

Figura 10.9 Transmissão de reforços *

Figura 10.10 Função ingénua de cálculo do reforço *

Figura 10.11 Função de cálculo do reforço baseada na utilidade média *

Figura 10.12 Curvas de negociação dos agentes MTA no cenário 5 *

Figura 10.13 Utilidades e utilidade média do agente 1ABAIIs1 *

Figura 10.14 Utilidades e utilidade média do agente 2ABAIIs1 *

Figura 10.15 Percentagem de acordos obtidos pelo agente 3ABAIIs1 *

Figura 10.16 Utilidades e utilidade média do agente 3ABAIIs1 *

Figura 10.17 Percentagem de acordos obtidos pelo agente 4ABAIIs1 *

Figura 10.18 Utilidades e utilidade média do agente 4ABAIIs1 *

Figura 10.19 Evolução dos desvios padrão dos agentes ABA e ABAII nos cenários 3 e 4 *

Figura 10.20 Utilidades e utilidade média do agente 5ABAIIs1 *

Figura 10.21 Utilidades e utilidade média do agente 6ABAIIs1 *

Figura A.1 Níveis do JATLite *

Figura B.1 Níveis do KQML *

Tabela 2.1 Sistemas baseados em agentes e o modelo CBB *

Tabela 4.1 Comparação de mercados electrónicos baseados em agentes *

Tabela 10.1 Pesos relativos das tácticas para os MTAs vendedores *

Tabela 10.2 Configuração do MTA comprador em cada cenário *

Tabela 10.3 Utilidades médias obtidas pelos agentes MTA *

Tabela 10.4 Configuração dos cenários com agentes ABA *

Tabela 10.5 Resumo dos resultados das experiências com agentes ABA *

Tabela 10.6 Configuração dos cenários com agentes ABAII *

Tabela 10.7 Configuração dos cenários dinâmicos com agentes ABAII *

Tabela 10.8 Resumo dos resultados das experiências com agentes ABAII *

Tabela B.1 Parâmetros KQML reservados *

Tabela C.1 Mensagens KQML trocadas entre os agentes e o mercado *

Tabela D.1 Mensagens KQML trocadas entre os agentes *

Este trabalho de dissertação é subordinado ao tema Sistema Multi-Agente para Comércio Electrónico. Tal como o nome indica, a motivação que levou à escolha deste tema foi a disponibilização na Web de um sistema que viabilizasse o Comércio Electrónico mediado por agentes. O trabalho desenvolvido gira em torno de duas áreas fundamentais: a negociação e a aprendizagem automáticas.

Foi portanto definido como objectivo a construção de um sistema informático baseado em agentes, representando um mercado onde agentes compradores e vendedores negoceiam de uma forma multi-lateral (várias negociações simultâneas) e multi-dimensão (a negociação pode decorre sobre vários atributos). O sistema denomina-se SMACE (Sistema Multi-Agente para Comércio Electrónico) e inclui a possibilidade de criação de agentes predefinidos ou utilização de agentes externos.

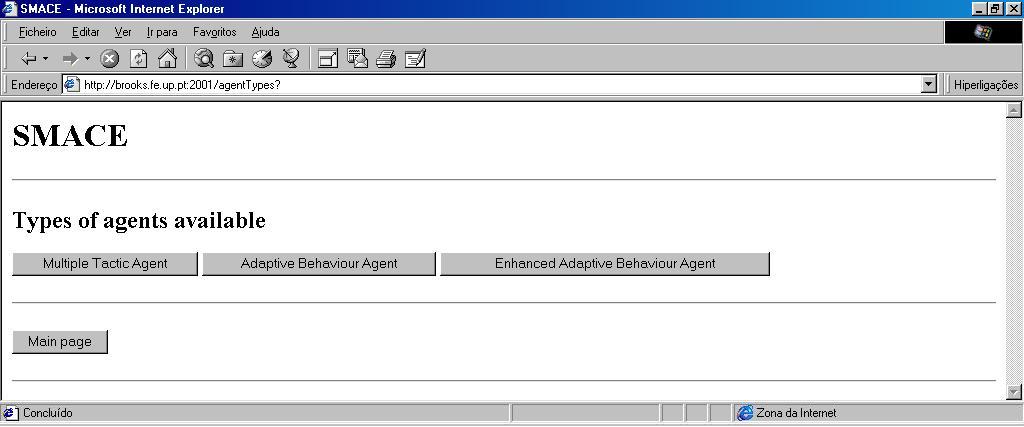

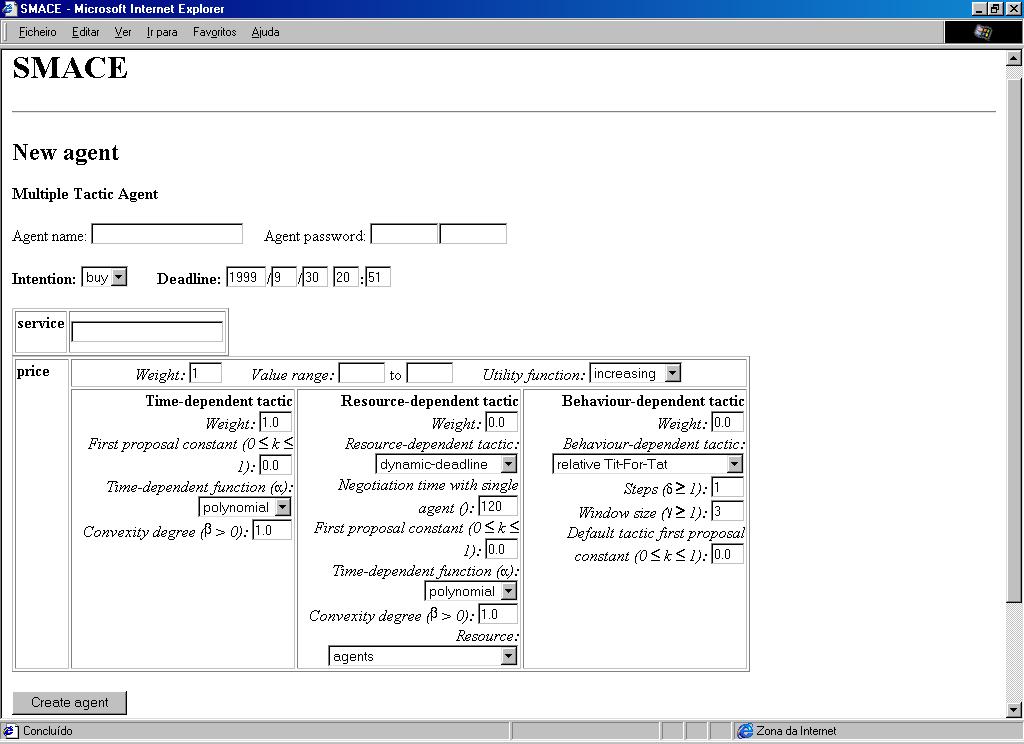

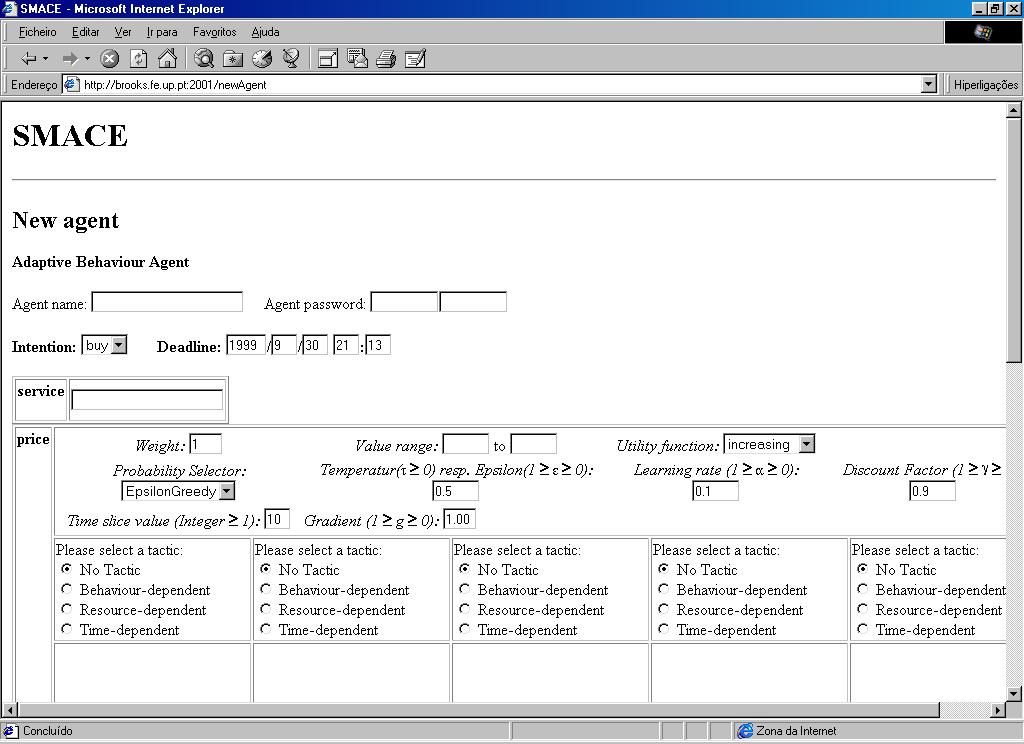

A construção deste sistema permitiu obter uma plataforma de testes para algo mais ambicioso: demonstrar que é possível dotar os agentes do mercado com capacidades de aprendizagem que lhes permitam, pela sua experiência, obter melhores resultados no processo de negociação. Esse processo de aprendizagem foi incluído num tipo de agente específico, tendo sido realizados testes para a avaliação do seu desempenho. O sistema inclui portanto dois tipos de agentes predefinidos com aprendizagem e sem aprendizagem , podendo cada um destes ser utilizado com um leque variado de opções no que diz respeito à sua estratégia de negociação. Além destes, o sistema admite ainda a interacção de agentes criados externamente com o mercado, e disponibiliza ferramentas que facilitam a sua construção.

As experiências conduzidas e relatadas no presente relatório não pretenderam simular situações reais de Comércio Electrónico. Elas foram executadas em cenários bem definidos, certamente limitados, mas nos quais pudemos avaliar o desempenho dos agentes dotados de aprendizagem desenvolvidos em contraste com agentes usando estratégias fixas.

A implementação inicial do algoritmo de aprendizagem nos agentes foi levada a cabo, no NIAD&R (Núcleo de Inteligência Artificial Distribuída & Robótica da FEUP e LIACC), sob a orientação do Prof. Eugénio Oliveira, por Max Schaefer, estando documentada em Schaefer (1999). A construção do sistema SMACE, bem como os resultados primários da sua utilização, encontra-se igualmente documentada em Lopes Cardoso et al. (1999).

O trabalho descrito neste relatório engloba várias áreas de conhecimento, tais como o Comércio Electrónico, sistemas multi-agente, negociação, aprendizagem e plataformas distribuídas. Estas áreas estão caracterizadas ao longo do relatório, com um grau crescente de detalhe, à medida que se vai apresentando o trabalho desenvolvido.

Na primeira parte do relatório é apresentado, de uma forma

abrangente, o "estado da arte" da área envolvente do presente trabalho.

O capítulo 1 introduz a temática do Comércio Electrónico

e a sua utilização na Internet. O capítulo 2 aborda

o conceito de agente, quer na perspectiva do indivíduo quer na sua

integração em sistemas multi-

-agente. Descreve ainda a forma pela qual esta tecnologia pode ser

e tem vindo a ser aplicada ao Comércio Electrónico. A negociação

em si, parte fundamental do nosso trabalho, é descrita no capítulo

3. O capítulo 4 descreve alguns dos mercados electrónicos

existentes baseados em agentes. Finalmente, no capítulo 5, é

abordada a aprendizagem automática e, em especial, a aprendizagem

em negociação.

Numa segunda parte deste relatório são descritas, mais pormenorizadamente, as metodologias adoptadas no desenvolvimento da tese. Assim, no capítulo 6 é descrito o sistema SMACE, incluindo alguns detalhes da sua implementação. O capítulo 7 debruça-se sobre as tácticas que os agentes utilizam para negociar. O capítulo 8 explica os dois tipos de estratégias incluídos nos dois tipos de agentes implementados. Finalmente, o capítulo 9 fornece pormenores sobre o tipo de aprendizagem automática utilizado e sua implementação.

Na terceira parte do relatório são apresentados os testes

e os resultados de utilização do SMACE. O capítulo

10 descreve as experiências conduzidas e explica algumas melhorias

introduzidas posteriormente nos agentes com aprendizagem, bem como os seus

efeitos. O capítulo 11 termina o relatório, apresentando

as conclusões mais relevantes do nosso trabalho.

O comércio é a forma pela qual clientes e fornecedores se encontram num determinado local e tempo, de modo a anunciar intenções de compra e venda, que eventualmente se correspondem provocando o início de transacções comerciais. Devido às inovações nas tecnologias de informação e comunicação durante os últimos anos, as restrições temporais e espaciais foram-se desvanecendo e, portanto, essas transacções comerciais tornaram-se mais fáceis [Rocha e Oliveira (1999)]. O Comércio Electrónico usa as tecnologias de informação e comunicação, possibilitando o suporte electrónico de documentos e, opcionalmente, a automatização dos processos de negociação e transacção.

1.1 O Comércio Electrónico no Contexto Actual

A popularidade da Internet e da "World Wide Web" (WWW) aumentou fortemente a importância e a necessidade do Comércio Electrónico. Contudo, este ainda não desenvolveu todo o seu potencial na redefinição do mercado no qual produtos e serviços são transaccionados. Algumas das razões que estão na origem deste atraso são os hábitos de compra dos consumidores, a confiança e segurança das transacções e o facto de estarmos na presença de modelos de mercado novos e portanto incertos [Moukas et al. (1998)]. Se bem que alguns destes problemas estejam a ser abordados por governos, pela indústria e por instituições de investigação, há ainda poucos procedimentos padrão adoptados, o que dificulta a sua resolução.

O processo tradicional de compra requer do consumidor um grande esforço, incluindo a procura de vendedores para o produto pretendido (por exemplo, pela consulta de catálogos), a comparação de preços e outras facetas do produto entre os vendedores disponíveis e, depois de a decisão estar tomada, a troca de dinheiro pelo produto, através de um canal acordado e idealmente seguro [Moukas et al. (1998), Terpsidis et al. (1997)].

Há cada vez mais empresas com sítios na "Web", possibilitando aos consumidores comprar via Internet. No entanto, a maioria destes sítios não alterou radicalmente a forma de comprar, consistindo muitas vezes em versões "on-line" de montras ou catálogos de produtos, com capacidades desenvolvidas de pesquisa. Alguns deles possibilitam a pesquisa de produtos através da procura de palavras, outros organizam os produtos por categorias, outros possuem ainda mecanismos mais avançados de pesquisa. Também referidos como "sítios de anúncios classificados", eles ajudam os utilizadores a encontrar anúncios de produtos do seu interesse, o que constitui apenas um passo do processo de compra.

Actualmente, a utilização da Internet como meio de compra e venda de produtos resume-se na sua essência ao anúncio electrónico criação de catálogos "on-line" e à pesquisa facilitada da informação constante nesses catálogos. Tem-se contudo verificado um aumento significativo do volume de transacções concretizadas via Internet, através de um número crescente de sítios que permitem a compra directa por pagamento electrónico.

O Comércio Electrónico envolve bastante mais do que a simples pesquisa de produtos expostos em montras ou catálogos virtuais e a comparação de preços. Engloba a automatização da negociação entre compradores e vendedores, com vista a encontrar um acordo quanto ao preço e outros termos da transacção. Trata também da encomenda de produtos e do pagamento electrónico.

A globalização do mercado está a pôr em causa a postura tradicional dos retalhistas face aos clientes. Estes últimos têm actualmente ao seu alcance um grande número de canais, fisicamente remotos. A descoberta de canais como a Internet afecta todos os retalhistas, independentemente da sua imagem de marca ou da sua dimensão. Com vista a explorar ao máximo o potencial do mercado na Internet, os vendedores "on-line" devem reorganizar radicalmente a sua política de "marketing". O envolvimento mais activo do consumidor no processo de compra deve ser utilizado para criar novos produtos, bem como para desenvolver novas estratégias de "marketing". Muitos retalhistas criaram já o seu sítio na "Web", disponibilizando aos utilizadores informação sobre a localização de lojas, promoções de venda, oportunidades de emprego e montras de produtos. No entanto, o problema principal é que, muitas vezes, torna-se difícil encontrar a informação específica que é necessária num determinado momento, para um determinado utilizador.

Os retalhistas na Internet enfrentam o mesmo tipo de problemas que o Comércio Electrónico, dado que a Internet ainda não desenvolveu todo o seu potencial. Os principais obstáculos são a segurança das transacções, a abundância de informação não estruturada e muitas vezes irrelevante e a falta de informação hierarquizada. Há alguns esforços no sentido de estabelecer processos padrão na forma como decorrem as transacções, visando ao mesmo tempo aumentar a segurança das mesmas. A falta de informação estruturada na Internet afasta possíveis consumidores. Embora haja tecnologias implementadas que permitem filtrar a informação relevante e disponibilizar recomendações sobre produtos, estas não foram integradas numa infra-estrutura de Comércio Electrónico, o que poderia abstrair o utilizador de alguns problemas relacionados com o excesso de informação. Esta, sendo hierarquizada, poderia permitir a construção de fontes de informação tipo "páginas amarelas", guiando o utilizador pelas lojas virtuais apropriadas [Terpsidis et al. (1997)].

O retalho de hoje pode ser descrito como uma competição entre vendedores pela preferência do cliente. Portanto, a relação que um vendedor deseja manter com os clientes é cooperativa e a longo prazo, procurando maximizar a sua satisfação. Isto aumenta a probabilidade de novas compras e a aquisição de novos clientes através de uma boa reputação. As novas tecnologias estão a alterar radicalmente o comércio por retalho. Actualmente existem já novos sistemas, baseados em agentes, que reduzem os custos de transacção entre vendedores e consumidores, e que ajudam os vendedores a aumentar as suas vendas. O acesso a sítios comerciais faz-se de uma forma cada vez mais rápida e automática através de agentes pesquisadores, o que torna a competição entre vendedores mais crítica. Contudo, algumas características do comércio a retalho não mudarão. Os consumidores irão continuar a preferir os vendedores que melhor satisfaçam as suas necessidades, e estes continuarão a desejar manter uma relação duradoura com os clientes [Guttman e Maes (1998b)].

Tem-se especulado sobre o papel dos intermediários nos mercados "on-line". Há quem acredite que terão tendência a desaparecer, à medida que as tecnologias substituem o seu trabalho (reduzindo custos de transacção) e que os produtores vendem directamente aos consumidores [Guttman e Maes (1998b)]. No entanto, no contexto actual, todos os tradicionais interlocutores comerciais têm possibilidade de estar presentes, com vantagem, no novo ambiente de negócio proporcionado pelo Comércio Electrónico.

1.2 A Expansão de Mercados Electrónicos

O crescimento da "Web" permitiu um aumento significativo das transacções electrónicas entre as organizações. Contudo, esta abertura do mercado, só por si, não conduziu a uma transformação radical na forma como as organizações se relacionam.

Nas formas de relacionamento electrónico entre as organizações continuam a distinguir-se dois mecanismos [Romm e Sudweeks (1998)]:

Há uma série de factores que podem influenciar a tendência para um dos mecanismos electrónicos referidos. Um deles diz respeito à descrição dos atributos dos produtos. Os produtos de menor complexidade são mais fáceis de descrever e procurar. Por esta razão, os mercados electrónicos desenvolver-se-ão primordialmente entre firmas que comercializam produtos simples. Um exemplo destes é o livro, que pode ser facilmente identificado através do ISBN. Um artigo difícil de identificar é por exemplo a fotografia, para a qual não existem descritores convencionais.

Outro factor importante é o grau de abertura da rede. Uma rede que facilita a comunicação entre as diferentes entidades, através da utilização de protocolos de domínio público, e cujos custos de ligação são baixos, é mais aberta e promove assim a interacção entre mais participantes.

A adesão de mais firmas a um ambiente de uma rede electrónica aberta depende também de quem controla a rede. Uma rede gerida por uma entidade independente do conjunto de vendedores e compradores conduz mais facilmente a relações de mercado entre estes.

Em redes de dados privadas, existentes principalmente antes do crescimento explosivo da Internet, as hierarquias electrónicas são mais comuns do que os mercados electrónicos [Romm e Sudweeks (1998)]. Ao contrário das redes de dados internas, que são usadas principalmente para reduzir os custos de operação, as redes externas permitem que as firmas criem novos serviços diferenciadores e produtos rentáveis. Contudo, o uso geral das redes abertas baseia-se no desenvolvimento de relações hierárquicas de longo prazo entre firmas. Os baixos custos das redes abertas permitem que estas relações hierárquicas se estendam mesmo a parceiros de negócio pequenos. Só quando as redes abertas se estendem ao consumidor final é que elas são usadas para suportar mercados electrónicos.

Para que o Comércio Electrónico se desenvolva, é necessária a presença de entidades que providenciem serviços de selecção como a procura de produtos, comparação e avaliação [Romm e Sudweeks (1998)]. Assim, para além dos poderes acrescidos que o Comércio Electrónico atribui a clientes e vendedores (globalização da oferta e da procura, automatização da negociação, etc.), também certo tipo de intermediários ganha importância e visibilidade, na disponibilização da informação relevante sobre o mercado em cada situação particular.

Está, portanto, criado todo o contexto de necessidades que apelam para o desenvolvimento das capacidades informáticas que suportem sistemas com as características interactivas pretendidas.

Agentes de "software" são programas de computador com algum grau de inteligência e autonomia, que tenderão a ser cada vez mais utilizados na execução de tarefas repetitivas e demoradas. Para que os agentes sejam realmente uma ajuda "inteligente", eles devem ainda aprender os interesses dos utilizadores, através de técnicas de aprendizagem automática.

A utilização de agentes em Comércio Electrónico permite a criação de mercados virtuais, onde os utilizadores delegam tarefas nos seus agentes, que se encarregam de as executar. Em vez de compradores e vendedores, podemos ter agentes de "software" compradores e agentes "software" vendedores que comunicam e negoceiam automaticamente entre si [Terpsidis et al. (1997)].

O comportamento do consumidor no processo de compra foi já estudado e analisado, tendo sido representado no modelo Consumer Buying Behavior (CBB) [Guttman et al. (1998c)], que detalhamos na secção 2.2. A tecnologia baseada em agentes pode ser aplicada a uma ou várias etapas desse modelo.

A Inteligência Artificial Distribuída (IAD) é um campo da inteligência artificial que se debruça sobre o estudo de entidades computacionais que interagem entre si, quer na perspectiva das suas capacidades internas quer na perspectiva da sua "sociabilização", incluindo a cooperação, levando à realização conjunta de objectivos predefinidos. Na IAD podem-se distinguir duas áreas principais, que estão intimamente relacionadas [OHare e Jennings (1996)]:

Existem inúmeras definições de agente, umas mais elaboradas do que outras, introduzindo propriedades mais exigentes e que ao mesmo tempo são mais subjectivas: é o caso da autonomia e da inteligência, por exemplo.

Uma definição abrangente de agente, que se aplica tanto a agentes humanos como a robots e agentes de "software", é a seguinte: um agente é algo que obtém conhecimento do seu ambiente através de sensores e actua nesse ambiente através de efectuadores [Russell e Norvig (1995)]. Uma outra definição, que pretende sintetizar o que possa haver de comum em todas as outras definições, diz que agentes de "software" são entidades computacionais persistentes e activas que percebem, raciocinam, agem e comunicam num ambiente [Huhns e Singh (1997)]. Sistemas multi-agente são conjuntos de agentes associados pela interacção num ambiente comum.

Um agente caracteriza-se por um conjunto de propriedades de domínio contínuo [Huhns e Singh (1997)]. Algumas dessas propriedades são intrínsecas do agente: tempo de vida (efémero a permanente), nível de cognição (reactivo a deliberativo), implementação (declarativo a procedimental), mobilidade (estacionário a móvel), adaptabilidade (fixo, ensinável ou autodidacta) e modelação (do ambiente ou de outros agentes). Outras são extrínsecas ao agente, definidas no contexto da sua relação com os outros: localização (local ou remoto), autonomia social (independente a controlado), sociabilidade (autista, atento, responsável ou membro), colaboração (cooperativo, competitivo ou antagonista) e interacção (com o ambiente e outros agentes).

O grau de sofisticação de um agente está directamente ligado à forma como ele selecciona as acções a tomar. O agente pode simplesmente reagir a eventos que ocorrem no mundo envolvente, utilizando um conjunto de regras "situação-acção" é o caso extremo de um agente reactivo. A tomada de decisão pode implicar um conhecimento prévio do mundo, que será memorizado pelo agente. Além disso, o agente pode ser gerido por objectivos, fazendo depender a escolha da acção a tomar do destino pretendido. O agente pode ainda basear as suas acções em funções de utilidade (medidas de satisfação para o agente). Neste extremo temos o agente deliberativo por excelência. O grau de sofisticação nem sempre é directamente proporcional ao desempenho do agente, pois em certos domínios (nomeadamente da robótica) um agente reactivo pode obter melhores resultados do que um agente dito deliberativo.

Uma noção de agente mais elaborada inclui na sua definição atitudes de informação acerca do mundo (conhecimento e crença) e pró-atitudes (intenções e obrigações) que guiam as acções do agente. Este tem a chamada arquitectura "BDI", onde a estrutura tripla <crença ("belief"), desejo ("desire"), intenção ("intention")> toma um papel activo no processo cognitivo do agente [OHare e Jennings (1996)].

A arquitectura típica básica de qualquer agente divide-se, de forma mais ou menos evidente, em duas partes:

O sistema inteligente é o componente que dá ao agente um carisma autónomo na resolução de problemas, capaz de tomar decisões inteligentes no que diz respeito à execução das suas tarefas. A camada de cooperação permite que os agentes troquem mensagens entre si, por forma a interagirem.

Em sistemas multi-agente são usadas duas estratégias principais para suportar a comunicação entre agentes [OHare e Jennings (1996)]:

Conceptualmente, o "blackboard" é um repositório onde os agentes escrevem mensagens e buscam informação. Esta informação encontra-se muitas vezes hierarquizada por níveis no "blackboard". Ao nível implementacional, contudo, este local pode funcionar como um agente auxiliar, com o qual os agentes comunicam de uma forma directa.

Os dois sistemas de comunicação podem ser combinados em sistemas complexos. Por exemplo, cada agente pode ser composto de vários subsistemas, que trocam informação utilizando um "blackboard" local; os agentes comunicam uns com os outros através da troca directa de mensagens.

A negociação entre agentes é a troca de mensagens, baseada num dado protocolo, com vista ao estabelecimento de um acordo. Um dos protocolos mais estudados para negociação foi inspirado nos processos contratuais das organizações humanas: é a Rede Contratual (Contract Net) [Smith (1988)]. Nesta, os agentes coordenam as suas actividades através de contratos para atingir determinados objectivos. Um agente organizador anuncia tarefas para o grupo de agentes contraentes potenciais. Estes respondem ao agente organizador com licitações para a execução das tarefas. O agente organizador avalia as propostas e escolhe a melhor, celebrando depois o contrato.

Seja para cooperar na prossecução de um determinado objectivo, seja para negociar de uma forma competitiva sobre um determinado recurso, os agentes têm necessidade de comunicar entre si. Para que essa comunicação seja possível, é imperioso que eles compreendam e utilizem uma linguagem comum.

Um dos grandes desafios para a compreensão entre agentes é que eles podem ter diferentes sistemas de crenças [Huhns e Singh (1997)]. Por exemplo, os agentes podem usar diferentes termos para o mesmo conceito. A utilização de uma representação comum é essencial para que a comunicação e coordenação tenham sucesso. Em agentes computacionais, isto representa uma ontologia comum uma representação do conhecimento de um dado domínio que é partilhada por todos os agentes. Esta partilha de ontologias permite uniformizar o conteúdo semântico do vocabulário utilizado.

A solução para o problema da interoperação entre agentes construídos por diferentes entidades passa pela definição de uma linguagem comum, normalmente referida como Agent Communication Language (ACL). Um dos trabalhos mais importantes nesta área é o desenvolvimento de uma linguagem para a troca de informação e conhecimento: a Knowledge Query Manipulation Language (KQML), desenvolvida pelo consórcio ARPA Knowledge Sharing Effort.

Conceptualmente, a linguagem KQML está dividida em três níveis [Finin et al. (1994, 1997)]:

Mais recentemente, a FIPA (Foundation for Intelligent Physical Agents) promoveu uma especificação de uma linguagem ACL, na tentativa de a padronizar.

Existem algumas plataformas desenvolvidas para facilitar a implementação de sistemas multi-agente. Estas plataformas providenciam uma infra-estrutura dentro da qual os agentes operam e interagem. Um dos aspectos principais destas infra-estruturas é o seu suporte para a comunicação entre agentes.

Algumas dessas plataformas são as seguintes:

O JATLite, desenvolvido na Universidade de Stanford, é um conjunto de programas escritos na linguagem Java, que possibilitam a criação rápida de agentes de "software" que comunicam de uma forma robusta pela Internet. O JATLite facilita especialmente a construção de agentes que enviam e recebem mensagens usando a linguagem de comunicação KQML, que tende à padronização. Contudo, o JATLite não impõe nos agentes nenhuma teoria ou técnica de construção de agentes autónomos. A construção de "agentes inteligentes" é da responsabilidade do programador. A infra-estrutura do JATLite assenta no chamado Agent Message Router (AMR). O AMR é uma aplicação Java que corre numa máquina ligada à Internet. Tem como funcionalidades principais o redireccionamento de mensagens entre os agentes e a manutenção da informação relativa aos endereços desses mesmos agentes. Os agentes podem ser portáteis ou móveis, embora o JATLite não assista a inclusão de mobilidade nos agentes. Eles registam-se no AMR usando um nome e "password", ligam-se e desligam-se de qualquer lugar da Internet e enviam e recebem mensagens.

A OAA, desenvolvida pela SRI, permite a construção de agentes utilizando uma linguagem de comunicação inter-agente declarativa, baseada em lógica (InterAgent Communication Language ICL). O enfoque está em construir comunidades distribuídas de agentes, onde estes são definidos como quaisquer processos de "software" que vão de encontro às convenções da sociedade OAA. Um agente satisfaz este requisito registando os serviços que pode fornecer de uma forma aceitável, sendo capaz de falar ICL e partilhando funcionalidades comuns a todos os agentes OAA, como a habilidade de disparar eventos, manipular dados de uma determinada maneira, etc.. Um agente especial, chamado facilitador, distribui tarefas pelos agentes.

A plataforma Voyager foi desenvolvida pela ObjectSpace. O seu propósito é o suporte a objectos móveis e agentes autónomos. A filosofia do Voyager assenta na noção de que um agente é simplesmente um tipo especial de objecto, que se pode mover independentemente, que pode continuar a executar enquanto se move e que de resto se comporta como qualquer outro objecto. Esta plataforma está implementada em Java, tirando partido de todas as vantagens de utilização desta linguagem. O Voyager providencia um Object Request Broker (ORB) para agentes construídos em Java, suportando alguns dos padrões mais comuns, como CORBA, RMI e DCOM. Um ORB é uma tecnologia intermediária que gere a comunicação e a troca de dados entre objectos. Outras plataformas semelhantes a esta, no que diz respeito à utilização de objectos e mobilidade, são a Odyssey da General Magic, a Aglets da IBM e a Concordia da Mitsubishi.

No presente trabalho foi utilizada a plataforma JATLite. As vantagens da sua utilização para o desenvolvimento pretendido estão descritas na secção 6.4.

2.2 O Modelo Consumer Buying Behaviour (CBB)

O modelo CBB propõe uma divisão do processo de transacção em seis etapas fundamentais [Guttman et al. (1998c)]:

Na perspectiva do modelo CBB, podem-se identificar os papéis dos agentes como mediadores no Comércio Electrónico. As características dos agentes (personalizados, semi-autónomos e inteligentes) tornam-nos apropriados para mediar estes comportamentos do consumidor, envolvendo a obtenção e filtragem de informação, avaliações personalizadas e coordenações/interacções com outros agentes. Estes papéis correspondem, principalmente, às etapas de Selecção do Produto, Selecção do Vendedor e Negociação do modelo CBB.

A tabela seguinte [Guttman et al. (1998c)] mostra as etapas de acção de alguns dos sistemas baseados em agentes existentes: PersonaLogic, Firefly, BargainFinder, Jango, Kasbah, AuctionBot e Tete-a-Tete.

|

|

|

|

|

|

|

|

|

| Selecção do Produto |

|

|

|

|

|||

| Selecção do Vendedor |

|

|

|

|

|||

| Negociação |

|

|

|

|

Os agentes são capazes de examinar rapidamente um grande número de produtos antes de tomar uma decisão de compra. Além de automatizar o processo de busca de informação, eles podem também negociar com os vários vendedores de um produto.

Na etapa de Selecção do Produto, o consumidor pretende identificar o que comprar.

PersonaLogic é uma ferramenta que permite aos consumidores limitar a gama de produtos que melhor correspondem às suas necessidades, a partir de um grande espaço de características de produtos. O consumidor utiliza estas características restringindo os valores que são desejáveis no produto que procura. Um motor de satisfação de restrições ordena depois uma lista de todos os produtos que obedecem às condições indicadas, utilizando para isso um conjunto de "restrições leves", indicadas pelo utilizador como preferências não obrigatórias.

Firefly é um outro sistema que também auxilia o utilizador a encontrar os produtos que procura. Este sistema faz recomendações baseado em opiniões fornecidas por outros utilizadores com interesses semelhantes. Este mecanismo tem o nome de "automated collaborative filtering".

Na etapa de Selecção do Vendedor, comparam-se as diferentes alternativas, em termos de vendedores. Obviamente que um vendedor preferia que os consumidores comprassem apenas no seu sítio na "Web". Contudo, os consumidores comparam os produtos de vários vendedores, o que tem vindo a ser facilitado por agentes de "software".

BargainFinder é um agente que automatiza a busca dos preços de um determinado produto a vários vendedores, apresentando-os ao utilizador. Este tipo de automatização faz com que o único critério utilizado para a decisão do consumidor seja o preço. Alguns vendedores, que não pretendem competir baseando-se apenas no preço, bloquearam os pedidos do BargainFinder.

Jango é uma optimização do BargainFinder que ultrapassa o problema do bloqueamento por parte dos vendedores, fazendo com que os pedidos sejam feitos do navegador da "Web" do utilizador.

Segundo Guttman e Maes (1998a), o aparecimento destes sistemas coloca problemas a ambas as partes do processo de compra. Se, por um lado, os vendedores não pretendem competir apenas baseados no preço, preferindo diferenciar-se através de outros aspectos inerentes à compra do produto, por outro lado os consumidores podem ser induzidos em erro quando são informados por estes sistemas. Por exemplo, um dos vendedores contactado, embora tendo um preço base mais elevado, poderia estar a fazer uma promoção, fazendo descontos na compra em quantidade. Um agente que ajude verdadeiramente o consumidor a realizar a melhor compra possível, deve considerar outros factores para além do preço, como a garantia, a assistência, modalidades de pagamento, etc., de acordo com as suas prioridades.

A diferenciação é necessária para um vendedor ter poder sobre o mercado, isto é, para que ele possa aumentar os preços dos seus produtos acima dos seus custos marginais. De outra forma, num mercado altamente competitivo, retalhistas e outros intermediários são obrigados a competir sobre os seus custos marginais, obtendo por isso pouco lucro [Guttman e Maes (1998a)]. A primeira geração de agentes de "software" que se destinam a comparar diversos vendedores baseia-se apenas no preço como termo de comparação. Isto torna bastante difícil a tarefa de diferenciação por parte dos vendedores.

Kasbah é um sistema "on-line" de "anúncios classificados", no qual pessoas interessadas em comprar (vender) produtos criam agentes compradores (vendedores), que entram em contacto com agentes vendedores (compradores). A procura de agentes com interesses complementares é feita de forma autónoma, depois dos agentes estarem devidamente parametrizados pelo utilizador. A etapa de Selecção do Vendedor desenrola-se a par da etapa de Negociação, que é feita baseada no preço do produto. Agentes compradores e vendedores negoceiam entre si, tentando cada um deles obter o melhor acordo possível [Guttman et al. (1998c)].

Tete-a-Tete é um novo sistema onde se pretende incluir funções multi-critério para avaliação de propostas no processo de compra, abrindo de novo a possibilidade da diferenciação. O sistema ordena as ofertas individuais dos vendedores de acordo com o seu valor global para o cliente.

Na etapa de Negociação, o preço e outros termos da transacção são determinados. Negociar dinamicamente o preço de um produto em vez de o fixar livra o vendedor de ter que determinar o valor do produto a priori. Esta tarefa fica entregue ao próprio mercado. O resultado é que recursos (produtos) limitados são atribuídos de uma forma justa, isto é, a quem os valoriza mais [Guttman e Maes (1998a, 1998b), Guttman et al. (1998c)]. Os leilões constituem casos típicos de negociação, sendo abordados na secção 3.2.

Há alguns obstáculos à utilização da negociação. Certos tipos de leilões requerem que todas as pessoas estejam no mesmo local. Além disso, a negociação pode ser demasiado complicada ou frustrante para o consumidor médio. Finalmente, alguns protocolos de negociação prolongam-na durante um longo período de tempo, o que não se adequa a consumidores sem disponibilidade para isso [Guttman et al. (1998c)].

Alguns destes impedimentos desaparecem no mundo digital. Existem diversos leilões instalados em sítios na "Web", e que portanto não requerem que os participantes estejam todos no mesmo local. No entanto, estes sítios requerem que os consumidores conduzam as suas próprias estratégias de negociação, por vezes durante longos períodos de tempo. É neste ponto que os agentes de "software" podem ter um papel importante.

Existem já alguns sistemas de agentes que assistem os consumidores no processo de negociação.

AuctionBot é um servidor de leilões. Os utilizadores criam novos leilões para vender produtos, escolhendo de entre um leque de tipos de leilões disponíveis e especificando os seus parâmetros. Vendedores e compradores podem licitar de acordo com os protocolos do leilão criado. Além disso, através de uma API disponibilizada pelo AuctionBot, os utilizadores podem criar agentes de "software" que, autonomamente, competem no mercado criado. Cabe aos utilizadores codificar as suas próprias estratégias de licitação. O sistema Fishmarket é de algum modo semelhante ao AuctionBot, mas admitindo apenas um tipo de leilão: o leilão holandês. Tal como no AuctionBot, no Fishmarket os utilizadores constróem as suas estratégias de licitação nos seus agentes. Este sistema não está a ser utilizado no mundo real, sendo usado como plataforma de testes para agentes com diversas estratégias, através da organização de torneios.

Kasbah é um sistema multi-agente, em que os agentes automatizam as etapas de Selecção do Vendedor e Negociação do modelo CBB, tanto para compradores como para vendedores. Após o encontro entre compradores e vendedores, a única acção válida no protocolo de negociação é, para os compradores, licitar e para os vendedores responder "sim" ou "não" [Guttman et al. (1998c)]. De acordo com a sua estratégia de negociação, os compradores aumentam o seu valor de licitação e os vendedores baixam o valor pedido. Há três estratégias disponibilizadas para utilização nos agentes, que correspondem a funções lineares, quadráticas e exponenciais para a alteração dos preços licitados/pedidos ao longo do tempo.

Tete-a-Tete é um sistema que permite aos agentes negociar segundo vários critérios, como a garantia, tempos de entrega, condições de pagamento e outros aspectos diferenciadores. A negociação entre os agentes é feita tendo em conta uma função de utilidade multi-atributo, que é usada para medir o grau de satisfação da oferta de cada vendedor. Na avaliação das propostas dos vendedores são usadas as restrições obtidas nas primeiras etapas do modelo CBB. Essencialmente, o Tete-a-Tete integra as etapas de Selecção do Produto, Selecção do Vendedor e Negociação [Guttman et al. (1998c)].

O tipo de relacionamento entre os agentes, no que diz respeito aos seus objectivos, pode ir de completamente cooperativo a antagónico [OHare e Jennings (1996)]. Agentes cooperativos são capazes de resolver problemas interdependentes. O objectivo global do sistema multi-agente está, neste caso, distribuído pelos agentes que dele fazem parte. Por outro lado, agentes antagónicos não cooperam e podem até bloquear os objectivos uns dos outros. No meio deste espectro há lugar à negociação, um processo pelo qual os agentes comunicam de uma certa forma para chegar a uma decisão comum.

Embora a negociação seja importante na modelação de sistemas multi-agente, não há uma definição clara e comum do que é a negociação [OHare e Jennings (1996)]. A ideia comum, em todas as contribuições no seio da IAD, é que os agentes usam a negociação para a resolução de conflitos e coordenação entre eles.

O recente acréscimo de interesse em agentes de "software" autónomos e interactivos, e a sua aplicação potencial em áreas como o Comércio Electrónico, aumentou a importância da negociação automática [Zeng e Sycara (1996, 1998)].

3.1 Negociação Competitiva vs. Cooperativa

A literatura sobre negociação em transacções comerciais define dois tipos de negociação [Guttman e Maes (1998a)]:

Mesmo em negociações competitivas, as entidades envolvidas necessitam de cooperar suficientemente, de forma a levar a cabo a própria negociação e a acordar nas semânticas dos protocolos de negociação utilizados.

Os objectivos dos vendedores são o lucro a longo prazo, vendendo o maior número de produtos possível, ao maior número de clientes possível, o mais caro possível e com o mínimo de custos de transacção. Os objectivos principais dos consumidores são satisfazer as suas necessidades através da compra de produtos apropriados a vendedores apropriados, o mais barato possível e com o mínimo de custos de transacção. A negociação cooperativa pode ajudar a maximizar ambos os conjuntos de objectivos [Guttman e Maes (1998a, 1998b)].

Existem ferramentas para analisar quantitativa e qualitativamente a tomada de decisões envolvendo múltiplos objectivos interdependentes. A teoria da utilidade multi-atributo (Multi-Attribute Utility Theory - MAUT) analisa preferências com múltiplos atributos. Esta teoria tem sido aplicada em vários tipos de problemas de decisão. Um sistema que utiliza MAUT é o Persuader [Sycara (1992)], usado para resolver conflitos através da negociação em problemas de grupo. Outro exemplo é o Logical Decisions for Windows (LDW), uma ferramenta que ajuda as pessoas a pensar e analisar os seus problemas. A teoria MAUT pode ajudar os consumidores a tomar decisões de compra. Pode também ajudar os vendedores na criação de políticas de valorização dos seus produtos, considerando o valor acrescentado proveniente da sua diferenciação [Guttman e Maes (1998a, 1998b)].

A teoria MAUT analisa quantitativamente os problemas de decisão, através de utilidades. Os problemas de satisfação de restrições (Constraint Satisfaction Problems CSP) requerem uma análise de índole qualitativa, através de combinações de restrições. Um CSP é formulado através de variáveis, domínios e restrições. A tarefa de um motor de CSP é atribuir valores às variáveis, ao mesmo tempo que garante a satisfação das restrições. Pode haver também a possibilidade de definir "restrições leves", que não precisam de ser verificadas, mas que são utilizadas na ordenação das soluções. Há muitos problemas que podem ser formulados como CSPs, tais como escalonamento, planeamento, etc.. Em mercados por retalho, técnicas de CSP podem ser usadas para definir "restrições pesadas" e "restrições leves". Um exemplo desse uso encontra-se no sistema PersonaLogic, que auxilia o utilizador na etapa de Selecção do Produto do modelo CBB. Um aspecto importante dos CSPs é que eles conseguem explicar porque tomam determinadas decisões (como nos sistemas periciais), o que conduz à confiança do utilizador no processo de decisão.

Sistemas como o PersonaLogic podem ser alargados, de forma a cobrir também as etapas de Selecção do Vendedor e Negociação do modelo CBB. Este alargamento pode ser feito utilizando técnicas de satisfação de restrições distribuídas (Distributed Constraint Satisfaction Problems - DCSP). DCSPs são semelhantes a CSPs, com a diferença de que as variáveis e restrições estão distribuídas pelos agentes [Yokoo et al. (1992), Yokoo e Hirayama (1998)] (no caso do comércio a retalho, consumidores e vendedores).

O sistema Tete-a-Tete combina técnicas de MAUT e DCSP para mediar as negociações entre agentes compradores e vendedores [Guttman e Maes (1998b)], baseando a negociação não apenas no preço de um produto, mas num conjunto de dimensões que são consideradas no processo de compra.

A negociação na Internet resume-se muitas vezes a uma das partes (tipicamente o vendedor) apresentar uma proposta de pegar ou largar (isto é, o preço de venda) é o que normalmente acontece no comércio por retalho, em que os preços são fixos. Os leilões são um espaço privilegiado para o estudo de protocolos de negociação entre agentes. Consistem numa abordagem mais geral à determinação do preço, admitindo diversos protocolos de negociação, incluindo o preço fixo como um caso especial [Wurman et al. (1998b)].

Um leilão é uma instituição de mercado, com um conjunto de regras, onde se determinam atribuições de recursos e preços, a partir de licitações dos participantes do leilão. Os leilões consistem em procedimentos formalizados para transacções comerciais, nos quais a interacção dos participantes é governada por regras específicas [Romm e Sudweeks (1998)]. Na maior parte dos casos, um leiloeiro funciona como intermediário.

Existem diversos tipos de leilões, cujas diferenças se baseiam nas regras utilizadas para a participação dos intervenientes:

Segundo Guttman e Maes (1998a, 1998b), apesar da crescente utilização deste tipo de Comércio Electrónico, os leilões "on-line" existentes têm características que fazem deles pouco compensadores, tanto para compradores como para vendedores. Embora alguns dos protocolos utilizados em leilões "on-line" sejam relativamente simples de compreender e utilizar, a determinação da melhor estratégia de licitação não é trivial. De facto, no leilão inglês, por exemplo, a licitação vencedora é quase sempre mais elevada do que o valor de mercado do produto. Este problema é conhecido como "a maldição do vencedor", sendo exacerbado em leilões onde os compradores valorizam os produtos por questões pessoais, tendendo irracionalmente a elevar as suas licitações acima do verdadeiro valor do produto. Embora a curto prazo isto possa representar um benefício para os vendedores, pode transformar-se rapidamente num problema, devido à possível insatisfação do cliente por ter pago mais do que o valor do produto. Há duas regras universais dos leilões que levam a isto: as licitações não são retiráveis e os produtos não podem ser devolvidos. Outro problema que leva à insatisfação do consumidor é o longo período que vai desde o início da fase de negociação até ao fim da fase de compra e entrega do produto, no modelo CBB. Alguns leilões na Internet podem demorar dias até que um licitador seja dado como vencedor. Além disso, dado que há apenas um vencedor, os outros consumidores terão que esperar até que o produto seja leiloado outra vez, reiniciando o processo de negociação. Outro problema que surge nos leilões é a utilização de "shills", que são licitadores ilegalmente criados por vendedores para viciar o jogo, estimulando o mercado através do aumento da sua licitação. Este tipo de mecanismo pode ser difícil de detectar, principalmente no mundo virtual.

Surgem também alguns problemas para os vendedores. Embora nos leilões estes não tenham que fixar o preço dos produtos que pretendem leiloar, quando se trata de bens de produção eles têm que determinar a quantidade dos bens a leiloar e a frequência dos seus leilões. Isto requer um conhecimento da procura do produto, afectando directamente a gestão de inventários e os planos de produção. Os compradores também podem viciar o jogo, formando coligações, que são grupos de compradores que acordam não licitar mais do que um determinado valor. Desta forma, podem ser comprados produtos mais baratos do que se os compradores estivessem a competir entre si. Tal como os "shills", as coligações podem ser difíceis de detectar, especialmente em mercados "on-line", onde os compradores são virtuais.

Na maior parte dos leilões "on-line" existentes, que consistem em mecanismos "single-sided", em vez de vendedores competirem entre si pela preferência dos clientes, os consumidores é que competem por ofertas específicas dos vendedores. Por outro lado, dado que a negociação nesses leilões se baseia no preço do produto, os vendedores perdem a oportunidade de se diferenciarem, na fase de Selecção do Vendedor do modelo CBB.

Em Shmeil e Oliveira (1995) as organizações são modeladas através de agentes. Este trabalho foca um tipo bem definido de interacções: as que ocorrem entre agentes representando organizações produtoras e fornecedoras. O intento dos produtores é encontrar o fornecedor mais adequado para um produto ou serviço. Uma acção cooperativa é estabelecida quando um fornecedor celebra um contrato com um produtor. Este contrato é o resultado de um processo de selecção, que consiste na publicação de um anúncio por parte do produtor, seguido da avaliação das propostas recebidas dos fornecedores. O contrato é celebrado com o primeiro fornecedor que satisfaça as restrições do produtor. Este modelo de negociação é baseado na Rede Contratual (Contract Net) [Smith (1988)].

Em Faratin et al. (1998) a negociação é

definida como um processo pelo qual uma decisão conjunta é

tomada por duas ou mais partes. As partes começam por exprimir exigências

contraditórias e chegam a acordo através de um processo de

concessões e de procura de novas alternativas [Pruitt (1981)]. O

trabalho desenvolvido em Faratin et al. (1998) debruça-se

sobre a negociação "orientada ao serviço": um agente

(o cliente) requer a execução de um serviço a outro

agente (o servidor). A negociação envolve a determinação

dos termos e condições do contrato. O modelo de negociação

adoptado é multi-lateral (como um CDA) e multi-dimensão.

A negociação decorre através da troca de propostas

entre os agentes, que vão concedendo nos valores pedidos/oferecidos

utilizando diversos critérios, como o tempo, a disponibilidade de

recursos ou o comportamento dos oponentes de negociação.

Existem já alguns sistemas multi-agente funcionais, que permitem automatizar grande parte do processo de compra e venda de produtos. Para facilitar o estudo de mecanismos de negociação entre os agentes que compõem os sistemas multi-agente, alguns deles baseiam-se em leilões, espaço privilegiado para a implementação da negociação.

Os sistemas mais significativos, que podem ser utilizados para investigação ou para transacções no mundo real, são o AuctionBot, o Fishmarket, o Kasbah e o Tete-a-Tete, os quais descreveremos neste capítulo.

O sistema AuctionBot, desenvolvido na Universidade de Michigan, é um servidor de leilões flexível, escalável e robusto, que suporta tanto agentes de "software" como agentes humanos [Wurman et al. (1998b)]. O sistema gere múltiplos leilões que poderão decorrer simultaneamente, admitindo vários tipos de leilões. Esta flexibilidade é alcançada decompondo o espaço dos leilões num conjunto de parâmetros ortogonais. Através destes parâmetros, o AuctionBot consegue implementar muitos dos tipos de leilões clássicos e mais alguns que nunca tinham sido estudados anteriormente.

Os leilões activos no AuctionBot são organizados num catálogo hierárquico, facilitando a pesquisa para os potenciais compradores que neles desejam licitar. Os utilizadores que pretendam criar novos leilões podem posicioná-los em qualquer secção do catálogo existente, ou expandir o catálogo, criando uma subcategoria apropriada. Têm também a opção de não listar o leilão no catálogo público, mantendo a sua visibilidade limitada a um grupo privado. Para participar em qualquer leilão, os utilizadores têm que se registar. Em qualquer momento, eles podem inspeccionar as suas contas através de uma página "Web", que apresenta uma visão organizada das suas licitações, leilões que eles iniciaram e transacções anteriores.

O AuctionBot disponibiliza uma API que permite aos utilizadores a criação de agentes, com estratégias de licitação por eles concebidas, que agem autonomamente. A interface com estes agentes de "software" é assegurada através de comunicação TCP/IP. Os humanos interagem com o sistema via uma interface "Web". A interacção entre os agentes externos ("software" e humanos) e o sistema AuctionBot consiste na utilização de uma base de dados, onde os agentes colocam as suas licitações. Esta base de dados é monitorizada pelo leiloeiro, que processa os eventos dos diversos leilões e verifica as licitações pendentes.

O suporte de uma grande variedade de tipos de leilões, combinado com a API disponibilizada para a criação de agentes, faz do AuctionBot uma plataforma útil tanto para o Comércio Electrónico como para a investigação [Wurman et al. (1998b)].

O Fishmarket é uma implementação de uma casa de leilões electrónica, inspirada na velha instituição do mercado da lota do peixe ("fish market") [Rodríguez-Aguilar et al. (1997)], tendo sido desenvolvido no Artificial Intelligence Research Institute de Barcelona. Neste sistema, agentes de "software" e humanos podem transaccionar. O Fishmarket não está a ser utilizado no mundo real, sendo usado como plataforma de testes de agentes com diversas estratégias, através da organização de torneios [Rodríguez-Aguilar et al. (1998a, 1998b)]. O protocolo utilizado no Fishmarket deriva directamente do modo como a venda de caixas de peixe é feita no mercado da lota do peixe. É o protocolo de "licitações descendentes", mais conhecido como leilão holandês.

No cenário do mercado da lota do peixe um leilão em que o leiloeiro apresenta caixas de peixe, anunciando preços por ordem decrescente existem vários agentes que desempenham funções bem definidas (agentes internos). Estes funcionam como intermediários, que o mercado utiliza para interagir com compradores e vendedores (agentes externos). Os agentes foram transferidos para a versão electrónica deste mercado, o Fishmarket. O patrão do mercado tem o papel de servidor de identidades, de supervisor do leilão e autoridade máxima. O leiloeiro encarrega-se do processo de licitação. Agentes vendedores registam os seus produtos num agente admissor de vendedores, recolhendo o seu dinheiro num gestor de vendedores, após o leiloeiro ter vendido os produtos no leilão. Os compradores registam-se num agente admissor de compradores, e licitam produtos que pagam através de uma linha de crédito que é mantida pelo gestor de compradores.

Os agentes externos (compradores e vendedores) podem ter diversos graus de complexidade, cabendo aos utilizadores construí-los, podendo ser eles próprios agentes. Todos eles participam no Fishmarket exclusivamente através de interfaces de comunicação padronizados. Para cada agente externo existe um interagent [Martín et al. (1998)], que serve de intermediário de comunicação entre o agente e o resto do mercado. Agentes externos podem ser construídos em qualquer linguagem de programação que permita lançar o interagent como um processo filho, comunicando com ele pelo "standard input/output" e com o mercado via TCP/IP.

Os diversos componentes do mercado Fishmarket foram implementados em

Java. Cada agente do mercado funciona como um processo com múltiplos

"threads" de execução, que lhe permite responder a vários

pedidos concorrentemente [Rodríguez-

-Aguilar et al. (1997)].

O Fishmarket permite avaliar o desempenho dos agentes compradores, através do registo de todas as suas intervenções no leilão. São organizados torneios em que participam diversos agentes compradores, podendo-se analisar comparativamente os seus resultados.

O Kasbah é um mercado virtual, criado no MIT Media Laboratory, no qual os utilizadores criam agentes predefinidos e nos quais delegam a compra e venda de produtos [Chavez e Maes (1996)]. O objectivo principal do sistema é permitir a criação de agentes que negoceiam autonomamente, procurando obter o melhor negócio possível para o utilizador. O Kasbah é um sistema de Comércio Electrónico baseado em mecanismos do tipo continuous double auction (CDA).

No Kasbah, os agentes vendedores são como anúncios classificados. Quando um utilizador cria um agente vendedor, dá-lhe uma descrição do produto que pretende vender. Estes agentes são pró-activos, ou seja, tentam vender o produto entrando no mercado, contactando com compradores interessados e negociando com eles, de forma a encontrar o melhor negócio possível. Os agentes vendedores são autónomos, pois uma vez largados no mercado eles negoceiam e tomam decisões, sem requerer a intervenção do utilizador. Ao criar um agente vendedor, o utilizador define alguns parâmetros para guiar o agente enquanto tenta vender o produto:

Os agentes compradores funcionam de forma análoga e simétrica aos agentes vendedores. Na sua criação, o utilizador define a data limite para a compra do produto, o preço desejado e o preço mais alto aceitável. O utilizador tem igualmente à sua disposição três funções para a subida do preço oferecido ao longo do tempo: linear (correspondendo a um agente "ansioso" por comprar o produto), quadrática (representando um agente de "cabeça fria") e cúbica (um agente "económico").

O mercado do Kasbah ajuda os agentes a encontrarem os seus pares (agentes interessados em comprar/vender aquilo que querem vender/comprar). Os produtos comprados e vendidos no Kasbah são descritos através de vectores de atributos (pares atributo/valor). Esta forma de representar os produtos facilita a sua comparação, bem como o encontro de agentes compradores e vendedores com interesses complementares. Depois de se encontrarem, os agentes comunicam directamente uns com os outros.

Assim que agentes compradores e vendedores chegam a acordo, e após a autorização dos respectivos utilizadores, a transacção física pode ocorrer. Este passo tem que ser dado pelos humanos. A última versão do Kasbah incorpora um mecanismo distribuído de confiança e reputação, chamado Better Business Bureau [Guttman et al. (1998c), Moukas et al. (1998)]. Quando uma transacção é finalizada, cada entidade envolvida pode avaliar a outra relativamente à forma como conduziu a sua parte do acordo. De forma a utilizar esta informação, os utilizadores têm ainda a possibilidade de indicar mais um parâmetro na criação dos seus agentes: o nível mínimo de reputação do dono dos agentes com os quais podem negociar.

No Kasbah, o mercado e os agentes são objectos (instâncias de classes). A sua execução em paralelo é simulada através de um algoritmo que faz circular fatias de tempo de execução por todos os objectos existentes. Os agentes e o mercado comunicam entre si invocando métodos por eles suportados. Esses métodos correspondem a um protocolo interno próprio, dado que todos os agentes estão predefinidos no sistema (utilizando as funções estratégicas acima descritas). Pretende-se evoluir para protocolos que permitam a comunicação entre agentes distribuídos por diversas máquinas, incluindo a possibilidade dos utilizadores criarem os seus próprios agentes, com as suas próprias estratégias, que interagem com o mercado Kasbah utilizando esses protocolos.

Uma experiência envolvendo cerca de 200 participantes na utilização do mercado do Kasbah, em Outubro de 1996, está relatada em Chavez et al. (1997) e Guttman et al. (1997). Desenvolvimentos mais recentes no MIT Media Laboratory levaram à criação do projecto PDA@shop [Zacharia et al. (1998)], que pretende interligar o mercado físico com o mercado virtual do Kasbah. O projecto consiste em proporcionar ao utilizador a possibilidade de comparar os preços obtidos no local de compra com preços alcançados no sistema Kasbah, além de obter informação sobre a reputação do vendedor. O utilizador pode, estando num local de venda, através de um Personal Digital Assistant (PDA), comunicar com o Kasbah e criar um agente comparador, que é um agente comprador com um tempo de vida mais limitado. O utilizador monitoriza os resultados do agente através do PDA, podendo-os comparar com o mercado físico. Este sistema estava em fase de testes no final de 1998.

O projecto Tete-a-Tete, desenvolvido no MIT Media Laboratory, engloba três áreas de investigação: sistemas multi-agente, desenho de interfaces homem-computador e Comércio Electrónico por retalho. O objectivo do projecto é disponibilizar tecnologias avançadas e ferramentas de visualização, para auxiliar o encaixe das necessidades dos consumidores com as ofertas dos vendedores, em mercados de retalho "on-line".

O Tete-a-Tete pretende dar aos utilizadores a possibilidade de negociar sobre várias dimensões de uma transacção. Dá a possibilidade aos vendedores de se diferenciarem em atributos do produto e do serviço além do preço, como tempos de entrega, garantia, etc. [Moukas et al. (1998)].

A negociação não utiliza funções simples de acréscimo e decréscimo de preços como no Kasbah. Em vez disso, os agentes compradores do Tete-a-Tete negoceiam argumentativamente com os agentes vendedores, utilizando as restrições de avaliação capturadas durante as etapas de Selecção do Produto e Selecção do Vendedor do modelo CBB, como dimensões de uma função de utilidade multi-atributo [Guttman et al. (1998c), Moukas et al. (1998)]. Esta função de utilidade é usada por um agente comprador para ordenar as ofertas dos vendedores, baseando-se em avaliar até que ponto elas satisfazem as suas preferências.

O Tete-a-Tete utiliza uma combinação de técnicas de MAUT e DCSP, para mediar as negociações entre agentes compradores e vendedores [Guttman e Maes (1998b)]. A negociação toma portanto a forma cooperativa, através de múltiplos termos da transacção.

Os mercados electrónicos descritos atrás diferem uns dos outros no que diz respeito, fundamentalmente, aos aspectos indicados na tabela 4.1.

|

|

|

|

|

|

||

| Tipo de sistema | servidor de leilões diversos | casa electrónica de leilões de tipo holandês | mercado virtual para compra e venda de produtos | mercado virtual para compra e venda de produtos | ||

| Objecto de negociação | preço | preço | preço | função de utilidade | ||

| Agentes de Software | Criação | pelo utilizador (API disponibili-zada) | pelo utilizador | agentes predefinidos e parametri-záveis | ||

| Estratégia | definida pelo utilizador | definida pelo utilizador | funções linear, quadrática e cúbica | |||

| Implementação | processos | processos | objectos | |||

| Comunicação | memória partilhada (base de dados) | TCP/IP, interface próprio (interagent) | invocação de métodos | |||

| Negociação | leilões conduzidos por agente leiloeiro | leilões conduzidos por agente leiloeiro | directa entre agentes comprado-res e vendedores | |||

| Disponibilidade | acessível na "Web" | não | acessível na "Web" | não | ||

Tabela 4.1 Comparação de mercados electrónicos baseados em agentes

Podemos portanto concluir, sobre os sistemas estudados, que:

Se o programador tem um conhecimento completo sobre o ambiente que o agente vai enfrentar, toda a "inteligência" requerida pode ser directamente implantada neste. Quando isto não acontece, isto é, quando o programador tem um conhecimento incompleto do problema, a aprendizagem é a única forma que o agente tem para adquirir os conhecimentos de que necessita [Russell e Norvig (1995)]. Neste caso, a construção do agente passa pela implementação de um algoritmo de aprendizagem.

A aprendizagem é um campo da Inteligência Artificial que pretende aumentar a capacidade dos programas, neste caso agentes, de serem capazes de lidar com situações nunca antes experimentadas. Esta área inclui uma vasta gama de metodologias e algoritmos de aprendizagem, que podem ser classificados segundo diversos parâmetros, como a estratégia de aprendizagem subjacente, a representação do conhecimento e o domínio de aplicação [Michalski et al. (1984)].

Quanto à estratégia de aprendizagem utilizada, uma forte distinção pode ser feita relativamente à necessidade de um supervisor. A aprendizagem supervisionada é a aprendizagem a partir de exemplos fornecidos por um supervisor externo. Estes exemplos são normalmente referidos como o conjunto de treino, contendo pares de entrada/saída. A aprendizagem consiste em induzir uma determinada função, procedimento ou regra de decisão, a partir do conjunto de treino constituído por instâncias, que permita classificar de forma aceitável um novo item de entrada. Um exemplo de aprendizagem por indução são as árvores de decisão, onde cada exemplo de treino fornecido é descrito por um conjunto de propriedades e um valor de saída que representa uma classe. A árvore de decisão, construída a partir dos exemplos de treino, é utilizada para classificar novas situações de entrada, descritas pelas mesmas propriedades. O programa C4.5 [Quinlan (1993)] permite gerar árvores ou regras de decisão desta forma.

Outro exemplo de aprendizagem para a representação de funções complexas são as redes neuronais [Rumelhart e McClelland (1986)], que pretendem modelizar o funcionamento do cérebro humano. São compostas por um conjunto de unidades (neurónios) interligadas entre si, sendo esta configuração definida pelo programador da rede neuronal.

As redes de crenças [Pearl (1986)] permitem elaborar representações probabilísticas de conhecimento incerto, utilizando para o efeito aprendizagem Bayesiana. A ideia é criar hipóteses a partir dos dados, que permitam depois realizar predições. Estas são feitas com base nas probabilidades de cada uma das hipóteses formuladas.

Em certos domínios, como em problemas onde a interacção é um aspecto central, ou em ambientes dinâmicos, a aprendizagem supervisionada não é aplicável, pela impossibilidade de obter exemplos de treino convenientes. A aprendizagem não supervisionada não exige a presença de exemplos de treino, derivando desse facto quer a sua importância quer a dificuldade da sua aplicabilidade.

A aprendizagem por reforço ("reinforcement learning") [Sutton e Barto (1998)] baseia-se nas interacções com o ambiente. Um agente aprende a executar as acções apropriadas em cada situação, através de um processo de recompensa das acções que produzem melhores resultados o agente aprende a partir da sua própria experiência.

Os algoritmos genéticos [Koza (1992)] fazem uma analogia à evolução das espécies, baseando-se no facto de que os indivíduos melhor adaptados ao ambiente tenderão a sobreviver. Esta abordagem começa por avaliar o "grau de adaptação" de cada indivíduo de um grupo inicial. Os indivíduos com mais sucesso são seleccionados e reproduzidos para a geração seguinte. Eles caracterizam-se por um conjunto de parâmetros chamados genes, que são depois combinados no processo de reprodução. A este tipo de algoritmos também se dá o nome de algoritmos evolutivos.

Existem vários outros métodos de aprendizagem. As referências apresentadas não pretendem ser exaustivas, mas sim dar uma visão geral das metodologias mais importantes, para podermos situar o tipo de aprendizagem por nós seleccionada para os agentes que desenvolvemos.

5.1 Aprendizagem em Negociação

A construção de agentes autónomos que melhoram a sua competência para negociar, baseando-se na aprendizagem a partir das suas interacções com outros agentes, é ainda uma área emergente [Zeng e Sycara (1996, 1998)].

Em Matos et al. (1998) é utilizado um modelo de negociação em que os agentes fazem variar os valores das suas propostas com base em determinados critérios, modelados por funções parametrizáveis chamadas tácticas, que podem ser combinadas de uma forma ponderada. Uma estratégia é definida como uma função que altera os pesos das tácticas a utilizar em cada instante. A aprendizagem implementada neste estudo consiste na utilização de algoritmos genéticos, que permitem gerar uma sequência de populações, cada vez melhor adaptadas à situação, como resultado de um método de pesquisa modelado por um mecanismo de selecção, combinação (recombinação de material genético de novas formas) e mutação (introdução de novo material genético por modificações aleatórias) [Matos et al. (1998)]. No caso apresentado, os indivíduos da população são agentes negociantes e os materiais genéticos são os parâmetros das tácticas e os seus pesos relativos. O objectivo é determinar quais as melhores estratégias e verificar como e quando estas estratégias evoluem, dependendo do contexto e comportamento de negociação dos oponentes.

Em Zeng e Sycara (1996, 1998) é descrito o sistema Bazaar, um

modelo de negociação sequencial que é capaz de aprender.

Nesse trabalho a negociação é modelada explicitamente

como uma tarefa sequencial de tomada de decisão, usando actualizações

Bayesianas como mecanismo de aprendizagem subjacente. No modelo Bazaar,

os agentes possuem informação acerca das condições

evolutivas do ambiente e dos modelos de outros agentes. A aprendizagem

Bayesiana é utilizada para actualizar o conhecimento e crença

que cada agente tem, sobre o ambiente e outros agentes. Um exemplo de informação

sobre um oponente, num processo de negociação para a transacção

de um determinado produto, é o valor do seu preço de reserva.

O comprador não sabe qual é o preço de reserva do

vendedor, dado que esta informação é privada. Contudo,

ele é capaz de alterar a sua crença acerca desse preço

de reserva, através das suas interacções com o vendedor

e do seu conhecimento sobre o domínio na área daquele negócio.

A actualização Bayesiana é probabilística,

e ocorre quando o comprador recebe novos sinais do ambiente ou do vendedor,

nomeadamente através da troca de propostas e contrapropostas. O

conhecimento do domínio é fundamental, para que esta informação

possa ser utilizada de forma eficiente.

No âmbito deste trabalho foi desenvolvido o sistema SMACE. Neste sistema os utilizadores podem criar agentes compradores e vendedores que negoceiam de uma forma autónoma, de modo a obter acordos sobre os serviços que procuram ou oferecem.

O esquema de mercado subjacente ao sistema SMACE é o representado na figura 6.1. O Mercado é uma entidade que representa o local onde os diversos agentes se encontram e através do qual negoceiam.

O sistema suporta duas etapas do modelo CBB, referido na secção 2.2:

O modelo de negociação adoptado tem as seguintes características:

Como regra geral, podemos dizer que os oponentes no processo de negociação têm interesses simétricos em todas as dimensões sobre as quais decorre a negociação. Contudo, pode acontecer que os agentes tenham interesses similares numa dimensão específica, portanto a evolução das propostas de ambos pode evoluir na mesma direcção.

Neste modelo de negociação, os agentes do mercado com objectivos comuns competem entre si de modo a obter o melhor acordo possível com um dos agentes com os quais estão a negociar. Por outro lado, agentes com objectivos complementares (compradores e vendedores de um mesmo produto) negoceiam entre si, cooperando no sentido de encontrar um acordo que constitua uma solução mutuamente aceitável.

O modelo multi-lateral e multi-dimensão implementado no sistema SMACE foi adaptado de Faratin et al. (1998). A negociação multi-lateral traduz-se num conjunto de negociações bilaterais a decorrer simultaneamente. A sequência de propostas e contrapropostas numa negociação bilateral denomina-se fluxo de negociação. Estas propostas e contrapropostas são geradas por combinações lineares de funções chamadas tácticas. As tácticas usam um certo critério (tempo, recursos, etc.) na geração de uma proposta para uma dada dimensão. Podem ser atribuídos pesos diferentes a cada uma das tácticas usadas na combinação referida, representando a importância de cada critério na tomada de decisão. Os agentes podem querer mudar a sua escala de importância de critérios ao longo do tempo. Para isso, eles usam uma estratégia, definida como a forma pela qual um agente altera os pesos relativos das diferentes tácticas que guiam a sua tomada de decisão ao longo do tempo.

Numa negociação sobre n dimensões, para cada dimensão j Î {1, , n}, cada agente i define:

Para o protocolo de negociação, assumiu-se que a entrega de mensagens é fidedigna e não se consideraram os atrasos das mensagens (porque são presumivelmente curtos).

Cada agente de mercado criado tem um determinado objectivo, que especifica a sua intenção de compra ou venda de um produto específico. Esse objectivo deve ser alcançado até um certo limite temporal tmax.

Um agente continua o seu processo de negociação até que uma de duas situações ocorra:

Num fluxo de negociação xa« b, os agentes a e b trocam uma sequência de propostas e contrapropostas. O procedimento do agente a, ao receber uma proposta xtbà a, é descrito pelo seguinte protocolo:

Dado que virtualmente poderão existir vários agentes no mercado a negociar simultaneamente, múltiplos fluxos de negociação podem estar activos num dado momento, para um dado agente. Quando um agente chega a acordo, desiste da negociação com todos os outros agentes com os quais estava a negociar. Um problema (ilustrado na figura 6.2) poderia surgir se um agente recebesse, consecutivamente, duas ou mais mensagens de aceitação das suas propostas, de outros tantos agentes (assumindo que o objectivo do agente admite a transacção de apenas uma unidade do produto, e portanto apenas um acordo pode ser consumado).

Para resolver este problema, quando um agente b recebe uma mensagem de aceitação da sua proposta de um agente a, responderá com uma confirmação do acordo, ou sua rejeição. Portanto, se o agente b ainda não chegou a acordo com nenhum outro agente, ele irá confirmar o acordo com o agente a, o emissor da mensagem de aceitação da proposta. Para garantir que apenas um acordo será efectuado, o agente a espera até receber uma resposta do agente b.

Um problema de "deadlock" poderia surgir se um grupo de agentes estivesse à espera de confirmações de acordos numa configuração em ciclo fechado (figura 6.3).